Google谷歌如何解读robots.txt规范

日期:2025年4月21日Google 的自动抓取工具支持 REP(robots 协议)。这意味着,在抓取某一网站之前,Google 抓取工具会下载并解析该网站的 robots谷歌object detection

Google 的自动抓取工具支持 REP(robots 协议)。这意味着,在抓取某一网站之前,Google 抓取工具会下载并解析该网站的 robots谷歌object detection

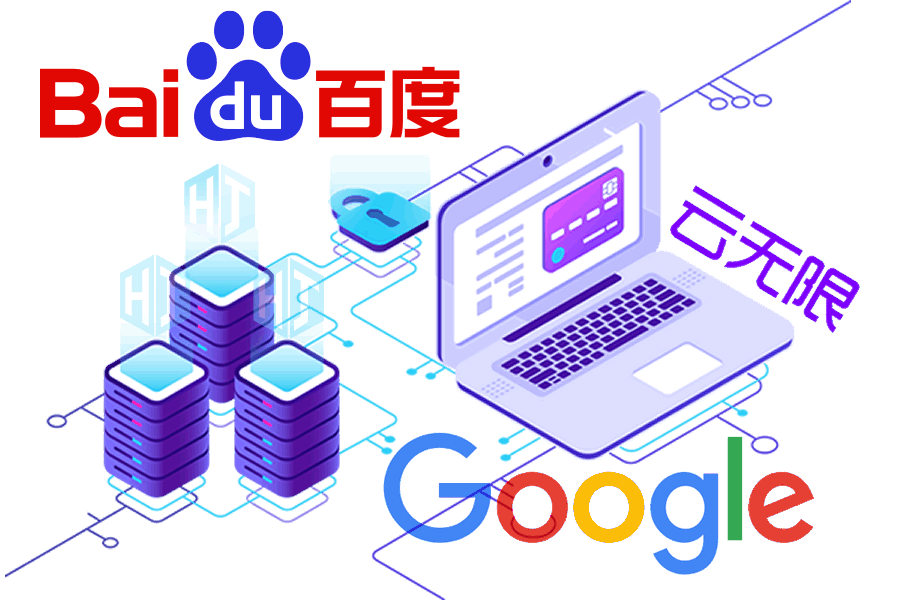

向搜索引擎要流量要订单!一个好网站不仅要满足用户需求还要符合SEO规则。

SEO的专业性远超你的想象!我们要做的是协助搜索引擎而不是欺骗它!它涉及到的不止是网站结构、内容质量、用户体验、外部链接这几个方面;还有算法的更替、蜘蛛的引导、快照的更新、参与排序的权重等。

一、让用户搜到你的网站是做SEO优化的目标,拥有精湛的SEO技术、丰富的经验技巧以及对SEO规则的深刻把握才有机会获得更多展现机会!

二、确保网站内容清晰、准确、易于理解,使用户能够轻松找到所需信息.使用简洁明了的标题和描述,帮助用户快速了解你的产品服务!

三、将企业的核心价值、差异化卖点、吸引眼球的宣传语等品牌词尽可能多的占位搜索前几页,增强用户印象,优化用户体验让访客信任你!

四、优化落地页引导用户咨询或预约留言,引用大型案例或权威报道彰显品牌实力,关注用户需求和反馈,不断优化产品服务让用户选择你!

让用户搜到你、信任你、选择你! <p> Google 的自动抓取工具支持 REP(robots 协议)。这意味着,在抓取某一网站之前,Google 抓取工具会下载并解析该网站的 robots.txt 文件,以提取关于网站中哪些部分可以被抓取的信息。REP 不适用于由用户控制的 Google 抓取工具(例如 Feed 订阅),也不适用于用来提高用户安全性的抓取工具(例如恶意软件分析)。</p><p> 本文介绍了 Google 对 REP 的解读。有关原始草稿标准的信息,请查看 IETF Data Tracker。 如果您是首次接触 robots.txt,请先阅读我们的 robots.txt 简介。您还可以找到关于创建 robots.txt 文件的提示,以及一个详尽的常见问题解答列表。</p><h3> 什么是 robots.txt 文件</h3><p> 如果您不希望抓取工具访问您网站中的部分内容,可以创建包含相应规则的 robots.txt 文件。robots.txt 文件是一个简单的文本文件,其中包含关于哪些抓取工具可以访问网站的哪些部分的规则。例如,example.com 的 robots.txt 文件可能如下所示:</p><p> # This robots.txt file controls crawling of URLs under https://example.com.</p><p> # All crawlers are disallowed to crawl files in the "includes" directory, such</p><p> # as .css, .js, but Googlebot needs them for rendering, so Googlebot is allowed</p><p> # to crawl them.</p><p> User-agent: *</p><p> Disallow: /includes/</p><p> User-agent: Googlebot</p><p> Allow: /includes/</p><p> Sitemap: https://example.com/sitemap.xml</p><h3> 文件位置和有效范围</h3><p> 您必须将 robots.txt 文件放在网站的顶级目录中,并为其使用支持的协议。就 Google 搜索而言,支持的协议包括 HTTP、HTTPS 和 FTP。使用 HTTP 和 HTTPS 协议时,抓取工具会使用 HTTP 无条件 GET 请求来提取 robots.txt 文件;使用 FTP 时,抓取工具会使用标准 RETR (RETRIEVE) 命令,并采用匿名登录方式。</p><p> robots.txt 文件中列出的规则只适用于该文件所在的主机、协议和端口号。</p><p> 和其他网址一样,robots.txt 文件的网址也区分大小写。</p><h3> 有效 robots.txt 网址的示例</h3><p> 下表列出了 robots.txt 网址及其适用的网址路径的示例。</p> <thead> robots.txt 网址示例 </thead> http://example.com/robots.txt 适用于:<br> http://example.com/<br> http://example.com/folder/file<br> 不适用于:<br> http://other.example.com/<br> https://example.com/<br> http://example.com:8181/<br> 这属于一般情况。该网址对其他子网域、协议或端口号来说无效。对同一个主机、协议和端口号上的所有子目录中的所有文件有效。 http://www.example.com/robots.txt 适用于: http://www.example.com/<br> 不适用于:<br> http://example.com/<br> http://shop.www.example.com/<br> http://www.shop.example.com/<br> 子网域上的 robots.txt 只对该子网域有效。 http://example.com/folder/robots.txt 不是有效的 robots.txt 文件。抓取工具不会检查子目录中的 robots.txt 文件。 http://www.ex?mple.com/robots.txt 适用于:<br> http://www.ex?mple.com/<br> http://xn--exmple-cua.com/<br> 不适用于:<br> http://www.example.com/<br> IDN 等同于其对应的 Punycode 版本。另请参阅 RFC 3492。 ftp://example.com/robots.txt 适用于: ftp://example.com/<br> 不适用于: http://example.com/ http://212.96.82.21/robots.txt 适用于: http://212.96.82.21/<br> 不适用于: http://example.com/(即使托管在 212.96.82.21 上)<br> 以 IP 地址作为主机名的 robots.txt 只在抓取作为主机名的该 IP 地址时有效。该 robots.txt 文件并不会自动对该 IP 地址上托管的所有网站有效,但该文件可能是共享的,在此情况下,它也可以在共享主机名下使用。 http://example.com/robots.txt 适用于:<br> http://example.com:80/<br> http://example.com/<br> 不适用于:<br> http://example.com:81/<br> 标准端口号(HTTP 为 80,HTTPS 为 443,FTP 为 21)等同于其默认的主机名。 http://example.com:8181/robots.txt 适用于: http://example.com:8181/<br> 不适用于: http://example.com/<br> 非标准端口号上的 robots.txt 文件只对通过这些端口号提供的内容有效。 <br/><h3> 错误处理和 HTTP 状态代码</h3><p> 在请求 robots.txt 文件时,服务器响应的 HTTP 状态代码会影响 Google 抓取工具使用 robots.txt 文件的方式。下表总结了 Googlebot 针对各种 HTTP 状态代码处理 robots.txt 文件的方式。</p> <thead> 错误处理和 HTTP 状态代码 </thead> 2xx(成功) 表示成功的 HTTP 状态代码会提示 Google 抓取工具处理服务器提供的 robots.txt 文件。 3xx(重定向) Google 会按照 RFC 1945 的规定跟踪至少五次重定向,然后便会停止,并将其作为 robots.txt 的 404 错误来处理。这也适用于重定向链中任何被禁止访问的网址,因为抓取工具会由于重定向而无法提取规则。<br> Google 不会跟踪 robots.txt 文件中的逻辑重定向(框架、Javascript 或元刷新型重定向)。 4xx(客户端错误) Google 抓取工具会将所有 4xx 错误解读为网站不存在有效的 robots.txt 文件,这意味着抓取将不受限制。<br> 这包括 401 (unauthorized) 和 403 (forbidden) HTTP 状态代码。 5xx(服务器错误) 由于服务器无法对 Google 的 robots.txt 请求提供明确响应,因此 Google 会暂时将服务器错误解读为网站完全禁止访问。Google 会尝试抓取 robots.txt 文件,直到获得非服务器错误的 HTTP 状态代码。503 (service unavailable) 错误会导致非常频繁的重试操作。如果连续 30 天以上无法访问 robots.txt,Google 会使用该 robots.txt 的最后一个缓存副本。如果没有缓存副本,Google 会假定没有任何抓取限制。<br> 如果您需要暂停抓取,建议为网站上的每个网址提供 503 HTTP 状态代码。<br> 如果我们能够确定,某网站因为配置不正确而在缺少网页时返回 5xx 而不是 404 状态代码,就会将该网站的 5xx 错误作为 404 错误处理。例如,如果返回 5xx 状态代码的网页上的错误消息为"找不到网页",我们会将该状态代码解释为 404 (not found)。 其他错误 对于因 DNS 或网络问题(例如超时、响应无效、重置或断开连接、HTTP 组块错误等)而无法抓取的 robots.txt 文件,系统在处理时会将其视为服务器错误。 <br/><h3> 缓存</h3><p> Google 通常会将 robots.txt 文件的内容最多缓存 24 小时,但在无法刷新缓存版本的情况下(例如出现超时或 5xx 错误时),缓存时间可能会延长。已缓存的响应可由各种不同的抓取工具共享。Google 会根据 max-age Cache-Control HTTP 标头来延长或缩短缓存生命周期。</p><h3> 文件格式</h3><p> robots.txt 文件必须是采用 UTF-8 编码的纯文本文件,且各行代码必须以 CR、CR/LF 或 LF 分隔。</p><p> Google 会忽略 robots.txt 文件中的无效行,包括 robots.txt 文件开头处的 Unicode 字节顺序标记 (BOM),并且只使用有效行。例如,如果下载的内容是 Html 格式而非 robots.txt 规则,Google 会尝试解析内容并提取规则,而忽略其他所有内容。</p><p> 同样,如果 robots.txt 文件的字符编码不是 UTF-8,Google 可能会忽略不属于 UTF-8 范围的字符,从而可能会导致 robots.txt 规则无效。</p><p> Google 目前强制执行的 robots.txt 文件大小限制是 500 KiB,并忽略超过该上限的内容。您可以通过整合会导致 robots.txt 文件过大的指令来减小 robots.txt 文件的大小。例如,将已排除的内容放在一个单独的目录中。</p><h3> 语法</h3><p> 有效的 robots.txt 行由一个字段、一个冒号和一个值组成。可以选择是否使用空格,但建议使用空格,有助于提高可读性。系统会忽略行开头和结尾的空格。若要添加注释,请在注释前面加上 # 字符。请注意,# 字符后面的所有内容都会被忽略。常见格式为 <field>:<value><#optional-comment>。</p><p> Google 支持以下字段:</p><p> user-agent:标识相应规则适用于哪些抓取工具。</p><p> allow:可抓取的网址路径。</p><p> disallow:不可抓取的网址路径。</p><p> sitemap:站点地图的完整网址。</p><p> allow 和 disallow 字段也称为指令。这些指令始终以 directive: [path] 的形式指定,其中 [path] 可以选择性使用。默认情况下,指定的抓取工具没有抓取限制。抓取工具会忽略不带 [path] 的指令。</p><p> 如果指定了 [path] 值,该路径值就是 robots.txt 文件所在网站的根目录的相对路径(使用相同的协议、端口号、主机和域名)。路径值必须以 / 开头来表示根目录,该值区分大小写。详细了解基于路径值的网址匹配。</p><p> <strong>user-agent</strong></p><p> user-agent 行用来标识相应规则适用于哪些抓取工具。请参阅 Google 抓取工具和用户代理字符串,获取可在 robots.txt 文件中使用的用户代理字符串的完整列表。</p><p> user-agent 行的值不区分大小写。</p><p> <strong>disallow</strong></p><p> disallow 指令用来指定不能被 disallow 指令所属的用户代理行所标识的抓取工具访问的路径。抓取工具会忽略不含路径的指令。</p><p> Google 无法将禁止抓取的网页的内容编入索引,但可能仍会将其网址编入索引并将其显示在搜索结果中,但不显示摘要。了解如何阻止编入索引。</p><p> disallow 指令的值区分大小写。</p><p> 用法:</p><p> disallow: [path]</p><p> <strong>allow</strong></p><p> allow 指令用来指定相应抓取工具可以访问的路径。如果未指定路径,该指令将被忽略。</p><p> allow 指令的值区分大小写。</p><p> 用法:</p><p> allow: [path]</p><p> <strong>sitemap</strong></p><p> 根据 sitemaps.org 规定,Google、Bing 和其他主流搜索引擎支持 robots.txt 中的 sitemap 字段。</p><p> sitemap 字段的值区分大小写。</p><p> 用法:</p><p> sitemap: [absoluteURL]</p><p> [absoluteURL] 行指向站点地图或站点地图索引文件的位置。 此网址必须是完全限定网址,包含协议和主机,且无需进行网址编码。此网址不需要与 robots.txt 文件位于同一主机上。您可以指定多个 sitemap 字段。sitemap 字段不依赖于任何特定的用户代理,只要未被禁止抓取,所有抓取工具都可以追踪它们。</p><p> 例如:</p><p> user-agent: otherbot</p><p> disallow: /kale</p><p> sitemap: https://example.com/sitemap.xml</p><p> sitemap: https://CDN.example.org/other-sitemap.xml</p><p> sitemap: https://ja.example.org/テスト-サイトマップ.xml</p><h3> 行和规则分组</h3><p> 通过对每个抓取工具重复 user-agent 行,可将适用于多个用户代理的规则组合在一起。</p><p> 例如:</p><p> user-agent: a</p><p> disallow: /c</p><p> user-agent: b</p><p> disallow: /d</p><p> user-agent: e</p><p> user-agent: f</p><p> disallow: /g</p><p> user-agent: h</p><p> 此示例中有四个不同的规则组:</p><p> 用户代理"a"为一组</p><p> 用户代理"b"为一组</p><p> 用户代理"e"和"f"为一组</p><p> 用户代理"h"为一组</p><p> 有关组的技术说明,请参阅 REP 的第 2.1 节。</p><h3> 用户代理的优先顺序</h3><p> 对于某个抓取工具而言,只有一个组是有效的。Google 抓取工具会在 robots.txt 文件中查找包含与抓取工具的用户代理相匹配的最具体用户代理的组,从而确定正确的规则组。其他组会被忽略。所有非匹配文本都会被忽略(例如,googlebot/1.2 和 googlebot* 均等同于 googlebot)。这与 robots.txt 文件中的组顺序无关。</p><p> 如果为用户代理声明多个特定组,则这些组中适用于该特定用户代理的所有规则会在内部合并成一个组。 特定于用户代理的组和全局组 (*) 不会合并。</p><p> 示例</p><p> user-agent 字段的匹配情况</p><p> user-agent: googlebot-news</p><p> (group 1)</p><p> user-agent: *</p><p> (group 2)</p><p> user-agent: googlebot</p><p> (group 3)</p><p> 以下为抓取工具选择相关组的方法:</p> <thead> 每个抓取工具追踪的组 </thead> Googlebot News googlebot-news 遵循组 1,因为组 1 是最具体的组。 Googlebot(网络) googlebot 遵循组 3。 Googlebot Images googlebot-images 遵循组 2,因为没有具体的 googlebot-images 组。 Googlebot News(抓取图片时) 抓取图片时,googlebot-news 遵循组 1。 googlebot-news 不会为 Google 图片抓取图片,因此它只遵循组 1。 Otherbot(网络) 其他 Google 抓取工具遵循组 2。 Otherbot(新闻) 抓取新闻内容但未标识为 googlebot-news 的其他 Google 抓取工具遵循组 2。即使有相关抓取工具的对应条目,也只有在明确匹配时才会有效。 <p> 规则分组</p><p> 如果 robots.txt 文件中有多个组与特定用户代理相关,则 Google 抓取工具会在内部合并这些组。例如:</p><p> user-agent: googlebot-news</p><p> disallow: /fish</p><p> user-agent: *</p><p> disallow: /carrots</p><p> user-agent: googlebot-news</p><p> disallow: /shrimp</p><p> 抓取工具会根据用户代理在内部对规则进行分组,例如:</p><p> user-agent: googlebot-news</p><p> disallow: /fish</p><p> disallow: /shrimp</p><p> user-agent: *</p><p> disallow: /carrots</p><p> allow、disallow 和 user-agent 以外的其他规则会被 robots.txt 解析器忽略。这意味着以下 robots.txt 代码段被视为一个组,因此 user-agent a 和 b 均受 disallow: / 规则的影响:</p><p> user-agent: a</p><p> sitemap: https://example.com/sitemap.xml</p><p> user-agent: b</p><p> disallow: /</p><p> 当抓取工具处理 robots.txt 规则时,会忽略 sitemap 行。 例如,下面说明了抓取工具如何理解之前的 robots.txt 代码段:</p><p> user-agent: a</p><p> user-agent: b</p><p> disallow: /</p><h3> 基于路径值的网址匹配</h3><p> Google 会以 allow 和 disallow 指令中的路径值为基础,确定某项规则是否适用于网站上的特定网址。为此,系统会将相应规则与抓取工具尝试抓取的网址的路径部分进行比较。 路径中的非 7 位 ASCII 字符可以按照 RFC 3986 作为 UTF-8 字符或百分号转义的 UTF-8 编码字符纳入。</p><p> 对于路径值,Google、Bing 和其他主流搜索引擎支持有限形式的通配符。这些通配符包括:</p><p> * 表示出现 0 次或多次的任何有效字符。</p><p> $ 表示网址结束。</p> <thead> 路径匹配示例 </thead> / 匹配根目录以及任何下级网址。 /* 等同于 /。结尾的通配符会被忽略。 /$ 仅匹配根目录。任何更低级别的网址均可抓取。 /fish 匹配以 /fish 开头的任何路径。<br> 匹配项:<br> /fish<br> /fish.html<br> /fish/salmon.html<br> /fishheads<br> /fishheads/yummy.html<br> /fish.php?id=anything<br> 不匹配项:<br> /Fish.asp<br> /catfish<br> /?id=fish<br> /desert/fish<br> 注意:匹配时区分大小写。 /fish* 等同于 /fish。结尾的通配符会被忽略。<br> 匹配项:<br> /fish<br> /fish.html<br> /fish/salmon.html<br> /fishheads<br> /fishheads/yummy.html<br> /fish.php?id=anything<br> 不匹配项:<br> /Fish.asp<br> /catfish<br> /?id=fish /fish/ 匹配 /fish/ 文件夹中的任何内容。<br> 匹配项:<br> /fish/<br> /animals/fish/<br> /fish/?id=anything<br> /fish/salmon.htm<br> 不匹配项:<br> /fish<br> /fish.html<br> /Fish/Salmon.asp /*.php 匹配包含 .php 的任何路径。<br> 匹配项:<br> /index.php<br> /filename.php<br> /folder/filename.php<br> /folder/filename.php?parameters<br> /folder/any.php.file.html<br> /filename.php/<br> 不匹配项:<br> /(即使其映射到 /index.php)<br> /windows.PHP /*.php$ 匹配以 .php 结尾的任何路径。<br> 匹配项:<br> /filename.php<br> /folder/filename.php<br> 不匹配项:<br> /filename.php?parameters<br> /filename.php/<br> /filename.php5<br> /windows.PHP /fish*.php 匹配包含 /fish 和 .php(按此顺序)的任何路径。<br> 匹配项:<br> /fish.php<br> /fishheads/catfish.php?parameters<br> 不匹配项: /Fish.PHP <br/><h3> 规则的优先顺序</h3><p> 匹配 robots.txt 规则与网址时,抓取工具会根据规则路径的长度使用最具体的规则。如果规则(包括使用通配符的规则)存在冲突,Google 将使用限制性最弱的规则。</p><p> 以下示例演示了 Google 抓取工具会对特定网址应用什么规则。</p> <thead> 示例情况 </thead> http://example.com/page allow: /p<br> disallow: /<br> 适用规则:allow: /p,因为它更具体。 http://example.com/folder/page allow: /folder<br> disallow: /folder<br> 适用规则:allow: /folder,因为存在多个匹配规则时,Google 会使用限制性最弱的规则。 http://example.com/page.htm allow: /page<br> disallow: /*.htm<br> 适用规则:disallow: /*.htm,因为它与网址中的字符匹配得更多,因此更具体。 http://example.com/page.php5 allow: /page<br> disallow: /*.ph<br> 适用规则:allow: /page,因为存在多个匹配规则时,Google 会使用限制性最弱的规则。 http://example.com/ allow: /$<br> disallow: /<br> 适用规则:allow: /$,因为它更具体。 http://example.com/page.htm allow: /$<br> disallow: /<br> 适用规则:disallow: /,因为 allow 规则仅适用于根网址。 <p> <br/></p> </p> </p> <p>TAG:谷歌object detection</p>

如果你的网站无法从搜索引擎获取流量和订单!说明你从一开始就没有建立正确的SEO策略。

1、不限关键词数量,不限关键词指数,自由扩展.

2、更懂用户搜索习惯、更懂SEO规则、更懂运营.

3、专业团队实施,量化交付、效果持续有保障.

1、让网站结构、内部标签及HTML代码等更符合SEO规则.

2、客户指定关键词,不限关键词指数,不上首页不收费.

3、提升搜索蜘蛛抓取效率、收录效率、排名展现和有效访问.

1、竞争对手分析,了解同行营销策略以及行业趋势.

2、关键词保证到谷歌首页带来高价值流量及询盘.

3、涵盖Google、Bing、Yahoo等所有搜索引擎友好抓取.

世界上从不缺产品,缺的是把产品卖出去的方法!云优化是北京专业的SEO公司,专注百度、谷歌、搜狗、360等搜索引擎优化服务。我们更懂用户搜索习惯、更懂SEO规则、更懂网站运营和SEO排名技术。

同等成本,让您的关键词排名更靠前;同样市场,为您锁定目标客户快速吸引询盘

用SEO技术让客户搜到你!让你的品牌词、核心词和产品词尽可能多的占位搜索首页让客户信任你!改进用户体验直达落地页,引导用户咨询或预约留言,突出产品差异化卖点,用案例和权威报道增强品牌公信力让客户选择你!

SEO网站优化是一项持续且精细化的工作,而非一劳永逸。它要求优化师密切关注行业动态,深入分析数据,并根据这些洞察不断调整和优化策略。云优化坚信,在SEO的旅程中,耐心和毅力是不可或缺的驱动力。只有持之以恒地投入努力,不断优化网站,才能在激烈的网络环境中脱颖而出,取得更为优异的搜索引擎排名。

搜索引擎优化聚焦于站内优化、站外SEO及搜索体验。以客户为中心,追求转化价值最大化,遵循用户需求和搜索规则,是成功的关键。文章作为优化的一环,不仅要满足读者,还需符合搜索引擎抓取规则。被收录的文章才有机会参与排序。因此,明确主题、合理结构、段落清晰,并结合关键词与主题的SEO规则创作,是文章发布的必备要素。

搜索引擎优化(SEO)与竞价推广共同构成了搜索引擎营销(SEM),因其精准满足客户搜索需求,成为中小企业网站营销的优选。SEM利用搜索引擎这一流量枢纽,精准捕获目标客户,助力品牌建设。无论在国内市场,借助百度、搜狗、360,还是国际市场,利用谷歌、必应、雅虎,SEM都能成为您营销的强大助力。无论国内还是国际,SEM都是一项高效、精准的营销策略。

许多优化师对SEO效果持疑,但云优化认为,这更多与网站SEO策略相关。关键词排名虽受多因素影响,但正确思维和规范操作是关键。在网站上线前,深入分析并调整SEO,确保站内优化到位。平衡用户需求和搜索引擎规则,可提升网站转化率。因此,科学的SEO策略将助力网站取得更好效果。